Von VMWare zu Proxmox: Unser Weg zur Effizienzsteigerung

Der Wechsel von VMWare zu Proxmox konnte erfolgreich abgeschlossen werden. Trotz anfänglicher Skepsis und einiger Hürden freuen wir uns über eine leistungsfähige und nicht zuletzt kostengünstige Virtualisierungsplattform.

Wie alles begann

Im Jahr 2021 begaben wir uns auf den Weg der VMWare-Proxmox-Migration. Zuerst etwas zögerlich – es waren durchaus Vorbehalte gegenüber der neuen Umgebung vorhanden.

Im Rückblick wurden von unserem Datacenter-Team über 100 Virtuelle Maschinen von VMWare 6 auf Proxmox VE transferiert.

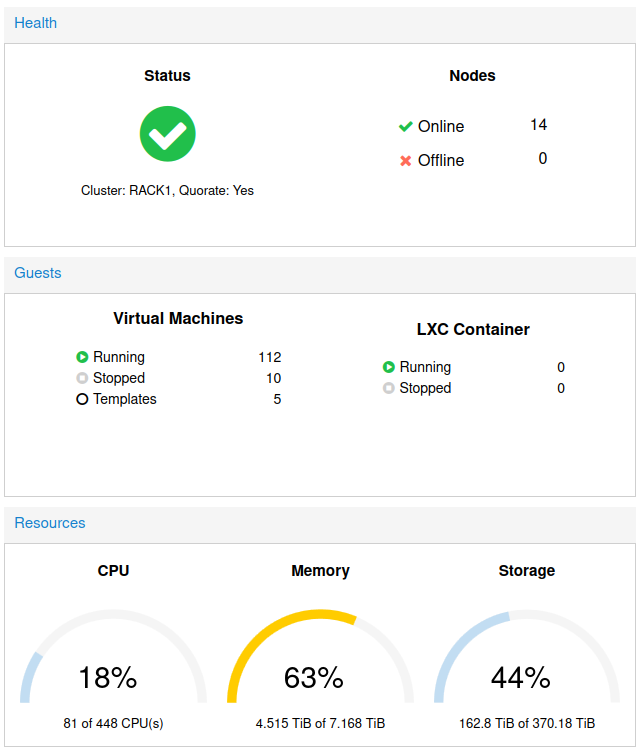

Schritt für Schritt wurden im neuen Proxmox-Cluster inzwischen 14 Virtualisierungsserver in Betrieb genommen und die OVA-Dateien von VMWare übertragen und importiert.

Voraussetzung war dazu, die VMWare-Infrastruktur parallel in der Proxmox-Welt aufzubauen. Dazu gehören vor allem die per FibreChannel angebundene SAN, die per iSCSI angebundenen NAS-Server sowie die Datensicherung mit einem per FibreChannel angebundenen LTO-Streamer/Wechsler.

Besonders entgegen gekommen ist uns die Tatsache, dass der Support der VMWare-SAN in diesem Zeitraum abgelaufen ist und parallel eine neue Storage zur Verfügung stand, so dass alle VM-Images ohne Altlasten auf der neue Storage eingerichtet werden konnten. Ein konvertieren des VMWare-Filesystems ins Proxmox-Format ist nicht vorgesehen. Proxmox kann auch VMFS nicht benutzen.

Herausforderung FibreChannel

Eine der größeren Herausforderungen war sicher die Bereitstellung der FibreChannel-SAN. FibreChannel ist durchaus eine hochpreisige Lösung und deshalb im Linuxalltag nicht so gängig als dass sich an jeder Ecke KnowHow findet.

Auch innerhalb der Proxmox-Welt sind die Informationen hierzu nicht so reichhaltig gesäht.

Letztendlich ist jedoch nur zwei Dateien anzupassen damit die Storage unter Proxmox eingebunden werden kann. Im Vergeleich zu VMWare, wo die Storage direkt über die Management-Oberfläche eingebunden wird, kommt man unter Proxmox leider um Kommandozeilentools nicht herum.

Überhaupt ist es bei Proxmox von Vorteil, wenn einem die Linux-Werkzeuge nicht völlig fremd sind (Stichwort ESC:wq!).

iSCSI-Anbindung

Die Anbindung der iSCSI-NASe geht dann dafür aber sehr flüssig von der Hand. iSCSI ist sehr verbreitet und in der Proxmox-Dokumentation gut beschrieben.

Import der VM-Images

Nachdem die Storages bereit standen, konnten die OVA-Images aus VMWare heruntergeladen und auf eine der Proxmox-Maschinen transferiert werden. In der damaligen Version Proxmox 8.1 erfolgte der Import der Images noch per Kommandozeilen-Aufruf und kurze Zeit später stand die VM innerhalb von Proxmox zur Verfügung.

Übrigens: Die signifikante Preiserhöhung bei VMWare-Lizenzen nach dem Kauf durch Broadcom motivierte Proxmox offensichtlich, den VMWare-Import-Vorgang zu überarbeiten. Bei Proxmox 8.3 können OVA-Images direkt über die Proxmox-Oberfläche heruntergeladen und importiert werden. Ein wirkliches Plus für Bash-scheue Administratoren.

Natürlich müssen vor dem Start der Virtuellen Maschine noch einige Kleinigkeiten angepasst werden, z.B. Zuordnung der Netzwerkinterfaces oder Aktivierung des QEMU-Guestagent (dem Pentant der VMWare-Tools).

Windows-VMs benötigen noch ein paar Handgriffe mehr, wofür es jedoch sehr gute Tutorials von Proxmox gibt.

Zusammenfassung

Zusammenfassend wurde das Migrations-Projekt aus unserer Sicht erfolgreich abgeschlossen. Nach anfänglichen Hürden (vor allem FibreChannel) wurden wir mit einer kostengünstigen Virtualisierungsumgebung belohnt, die den Vergleich mit VMWare nicht scheuen muss.

Wir verfügen jetzt über ein hochverfügbares VM-Cluster mit redundanter Storageanbindung mit einem einmaligen Kosten-Nutzen-Verhältnis.

Ganz ohne Kommandozeile wird es nicht gehen, aber wir freuen uns, dass sich Proxmox auch hier weiterentwickelt und die Funktionen der Managementoberfläche von Version zu Version erweitert.

Unsere Komponenten

Für die bessere Einschätzung noch die Eckpunkte unseres Clusters

- VMs:

110+, redundant HA - VMServer:

14+ (Intel und AMD) - Guest-Betriebssysteme:

Windows XP, Windows 10, Windows Server 2016, Windows Server 2022,

diverse Linuxe SuSE SLES, RHES, aktuelle Debian und Ubuntu-Server - Storage:

Hitachi G200 und G350 per FC

QNAP und diverse per iSCSI - Bereitgestellter HD-Space:

350+ TByte - Datensicherung:

ProxMox Backup (Backup-To-Disk / Disk-To-Tape)

Quantum LTO-Streamer/Tape-Library per FibreChannel

Aussicht

FC-Karten werden inzwischen nur noch von Broadcom hergestellt und sind sehr schlecht lieferbar. Wir möchten die teuere FibreChannel-Architektur deshalb duch einen modernen Object-Store ersetzen.

Unsere Wahl ist hier auf Ceph gefallen, das von Proxmox direkt native unterstützt wird. Erste Versuche in der Testumgebung sind sehr vielversprechend und unserem Weg zum Hyper Convergent Cluster steht nichts im Weg.